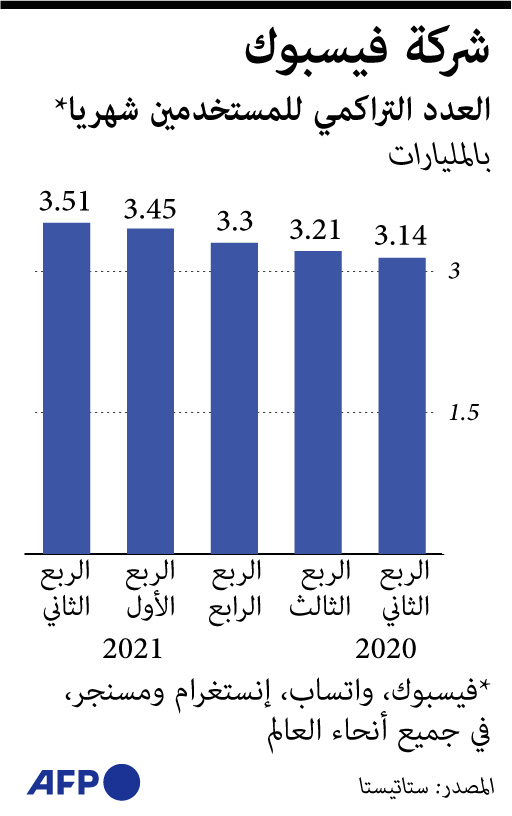

مش عارفين يفرقوا الضار من النافع.. ورطة في "فيسبوك" حول آلية عمل الذكاء الاصطناعي

لطالما زعم مديرون تنفيذيون في فيسبوك، أن أنظمة الذكاء الاصطناعي لديها القدرة على معالجة "المشاكل المزمنة" لتحييد المنشورات التي تدعو للكراهية والعنف، وسط تشكيك من مهندسين في الشركة.

وبحسب وثائق قالت "وول ستريت جورنال": إنها اطلعت عليها فحتى الآن لا تزال أنظمة الذكاء الاصطناعي في فيسبوك غير قادرة على التمييز ما بين المحتوى الضار من غيره، وعلى سبيل المثال، تظل الأنظمة عاجزة عن التفريق ما بين محتوى عن مصارعة الديوك وآخر عن حوادث السيارات.

وتشير الوثائق إلى أن موظفين من فيسبوك، قدَّروا أن خوارزميات الشبكة الاجتماعية الأكثر انتشارًا، تستطيع إزالة "جزء صغير" فقط من المنشورات التي تنتهك قواعدها، وهي نسبة بسيطة مما يتم نشره.

تحييد المحتوى الضار

واستبدلت فيسبوك قبل عامين عددًا كبيرًا من الأشخاص الذين كانوا يراجعون المحتوى والتأكد من أنه ضار أم لا، وإحلال أنظمة الذكاء الاصطناعي مكانهم، وهو ما جعل الشركة أكثر اعتمادًا على هذه الأنظمة، وهو ما تسبب بـ"تضخيم نجاحاتها".

ويقر مسؤولون في فيسبوك أن الأنظمة غير قادرة على تحييد المحتوى الضار والتأكد منه بشكل موثوق، بحسب الوثائق التي نقلت الصحيفة محتواها.

وفي 2019، كتب أحد المختصين في الشركة في مذكرة "أن المشكلة تكمن في أن فيسبوك لا تمتلك نموذجًا يلتقط غالبية المحتوى الضار، خاصة في بعض الأمور الحساسة".

ويقدّر المختص بأن الأنظمة المستخدَمة استطاعت إزالة 2 في المئة فقط من المحتوى الذي يضم خطابًا للكراهية، أو ما ينتهك قواعد فيسبوك، مشيرًا إلى أنه من الصعب تحسين ما يتعلق بالمحتوى بنسب تصل إلى 10-20 في المئة.

وفي مارس الماضي، أكد فريق آخر من موظفي فيسبوك ما جاء بهذه المذكرة، إذ أشار إلى أن خوارزميات فيسبوك رصدت 3-5 في المئة من منشورات تحتوي على خطاب للكراهية، وأن أقل من واحد في المئة منه كان يتعلق بمنشورات عن العنف والتحريض عليه.

آندي ستون، متحدث من فيسبوك قال لوول ستريت جورنال، إن هذه النسب المئوية تشير إلى ما تمت إزالته عبر أنظمة الذكاء الاصطناعي ولا تتضمن ما يتم إزالته عبر الأنظمة المختلفة الأخرى.

الثقة بأنظمة الذكاء الاصطناعي

وتتناقض الإحصائيات مع "الثقة في الذكاء الاصطناعي" التي يقدمها المسؤولون التنفيذيون، بما في ذلك تصريحات مؤسس الشركة، مارك زوركربيرج، الذي قال في تصريحات سابقة: إنه يتوقع أن تستخدم هذه الأنظمة للكشف عن "الغالبية العظمى من المحتوى الضار بنهاية 2019".

وتقول فيسبوك في كثير من الأحيان: إن "الذكاء الاصطناعي اكتشف كل الكلام الذي يحض على الكراهية تقريبًا قبل أن يبلغ عنه المستخدمون"، ويطلق على هذا الرقم "معدل الاكتشاف الاستباقي" وقد وصل نسبته إلى ما يقرب من 98 في المئة في وقت سابق من هذا العام.

وتشكك مجموعات متخصصة في الحقوق المدنية وأكاديميون بأن "معدل اكتشاف الذكاء الاصطناعي يقدم أرقامًا ذات قيمة" مؤكدين أنه لا يبدو أنه يتطابق مع تجارب المستخدم أو دراساتها الأكاديمية.

تقليص حجم المنشورات الضارة

رئيس مجموعة الحقوق المدنية "كلر أوف تشينج"، رشاد روبنسون، يقول: إن فيسبوك لن تعرض حقيقة عملهم أبدًا، وهو ما دعاهم إلى تنظيم حملة العام الماضي لمقاطعة فيسبوك، بسبب "فشل الشركة في السيطرة على خطاب الكراهية".

جاي روزن، رئيس قسم النزاهة في"فيسبوك"، قال إنه من الأهمية النظر إلى نقاط البيانات التي تظهر تقلص حجم المنشورات التي تحض على الكراهية كنسبة مئوية مما يراه الأشخاص على شبكة فيسبوك بشكل عام.

وتقول فيسبوك: إن خمسة من كل 10 آلاف منشور تشمل محتوى ضارًا يحض على الكراهية، وهو تحسن من حوالي 10 من كل 10 آلاف منشور في منتصف عام 2020، وفق تقرير صادر عن فيسبوك لنتائج الربع الثاني من العام الحالي.

ويؤكد روزن أن الانتشار هو المقياس الأكثر أهمية، وهو المقياس الأساسي الذي نحمّل أنفسنا المسؤولية تجاهه.

أنظمة ساذجة

المتحدث الرسمي باسم فيسبوك يقول إن الكثير من التحسن في هذه الأرقام جاء لأن الذكاء الاصطناعي يصنف المحتوى المشتبه به في مرتبة أدنى مما يجعله أقل انتشارًا.

وتعد خوارزميات الفرز للمنشورات، حجر الأساس لمراقبة المحتوى عبر شبكة فيسبوك، حيث تقوم بمسح مليارات المنشورات بحثًا عن عناصرَ محددة تتطابق مع تعريفات المحتوى الذي ينتهك قواعدها.

أحد المهندسين في الشركة اعتبر أن هذه الأنظمة لا تزال "ساذجة"، مشيرًا إلى أنها لا تزال بحاجة إلى تطوير كبير.